Article Reranking by Memory-Enhanced Key Sentence Matching for Detecting Previously Fact-Checked Claims

Article Reranking by Memory-Enhanced Key Sentence Matching for Detecting Previously Fact-Checked Claims

论文:Article Reranking by Memory-Enhanced Key Sentence Matching for Detecting Previously Fact-Checked Claims

代码:https://github.com/ictmcg/mtm

会议:ACL 2021

参考:https://zhuanlan.zhihu.com/p/393615707

飞书:https://zlc6vppbrn.feishu.cn/docx/QHgRdU0CtoLBipxyx86cZ807nec

任务

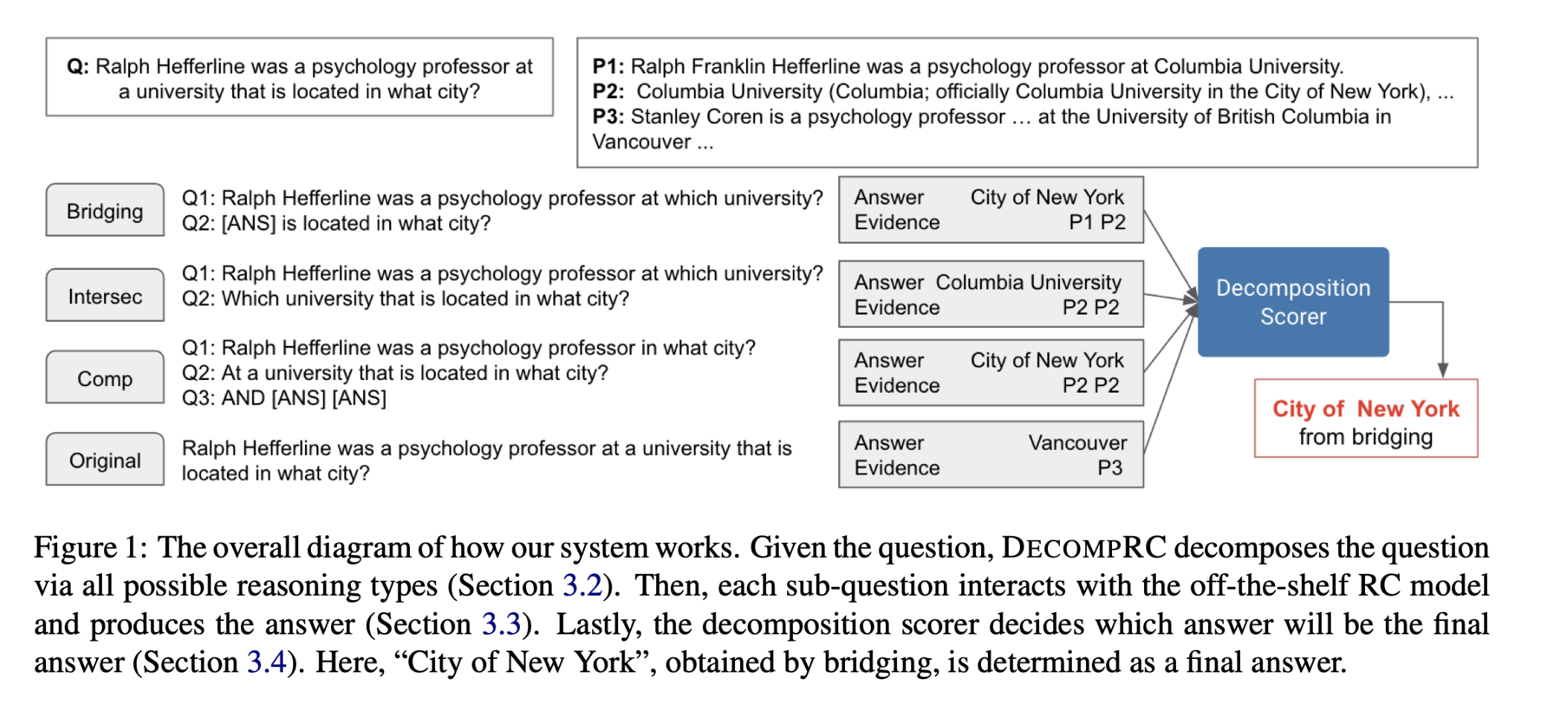

以前经过事实核查的假声明仍然可以在社交媒体上传播。 为了减轻它们的持续传播,检测以前经过事实核查的声明是必不可少的。 在典型的两阶段检索框架中,现有的工作是检索事实核查文章(FC-articles)进行检测,重点是对候选文章进行重新排序。然而,由于它们忽略了语料库冠词的以下特点,它们的表现可能受到限制:

- 经常引用声明来描述被检查的事件,除了提供语义之外,还提供词汇信息。

- 介绍或揭穿声明的句子模板在文章中很常见,提供模式信息。

方法(模型)

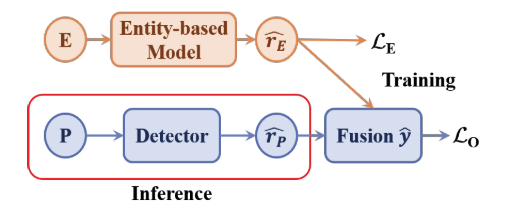

本文提出了一种新的重排序器MTM(MemoryEnhanced Transformers for Matching),利用事件(词汇和语义)和模式信息选择关键句子对FC(fact-checking)文章进行排序。

- 对于事件信息,我们建议微调Transformer with regression of ROUGE.

- 对于模式信息,我们生成模式向量作为存储库,与包含模式的部分进行匹配。

通过融合事件和模式信息,我们选择关键语句来表示一篇文章,然后使用声明、关键语句和模式来预测文章是否对给定的声明进行了事实检验。

问题定义

$q :声明\ k1:候选集\ D:FC-articles$D 由BM25检索得到

$文档S句子集合:S = {s_1, …, s_l}$

实现:Memory-enhanced Transformers for Matching (MTM)

关键句识别

对于每一个句子,从Rouge-Guided Transformer(ROT)和Pattern Memory Bank(PMB)中得到claim-sentence相关性得分。 分数表明句子与声明和模式向量的相似性,即成为关键句子的可能性。

文档相关性预测

选择top-k2句子用于与声明和模式向量的更复杂的交互和聚合。 聚合向量用于最终预测。

Key Sentence Identification

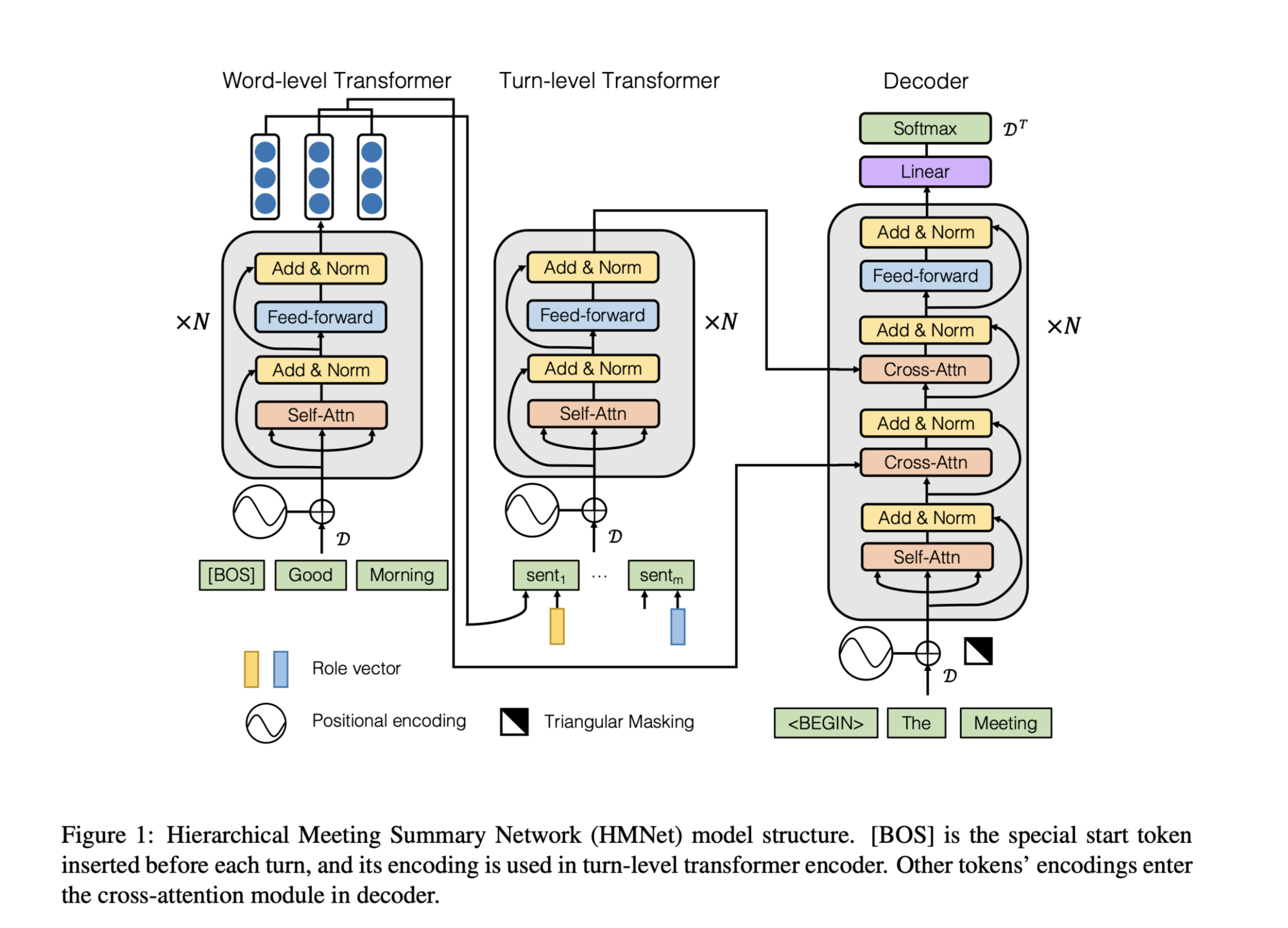

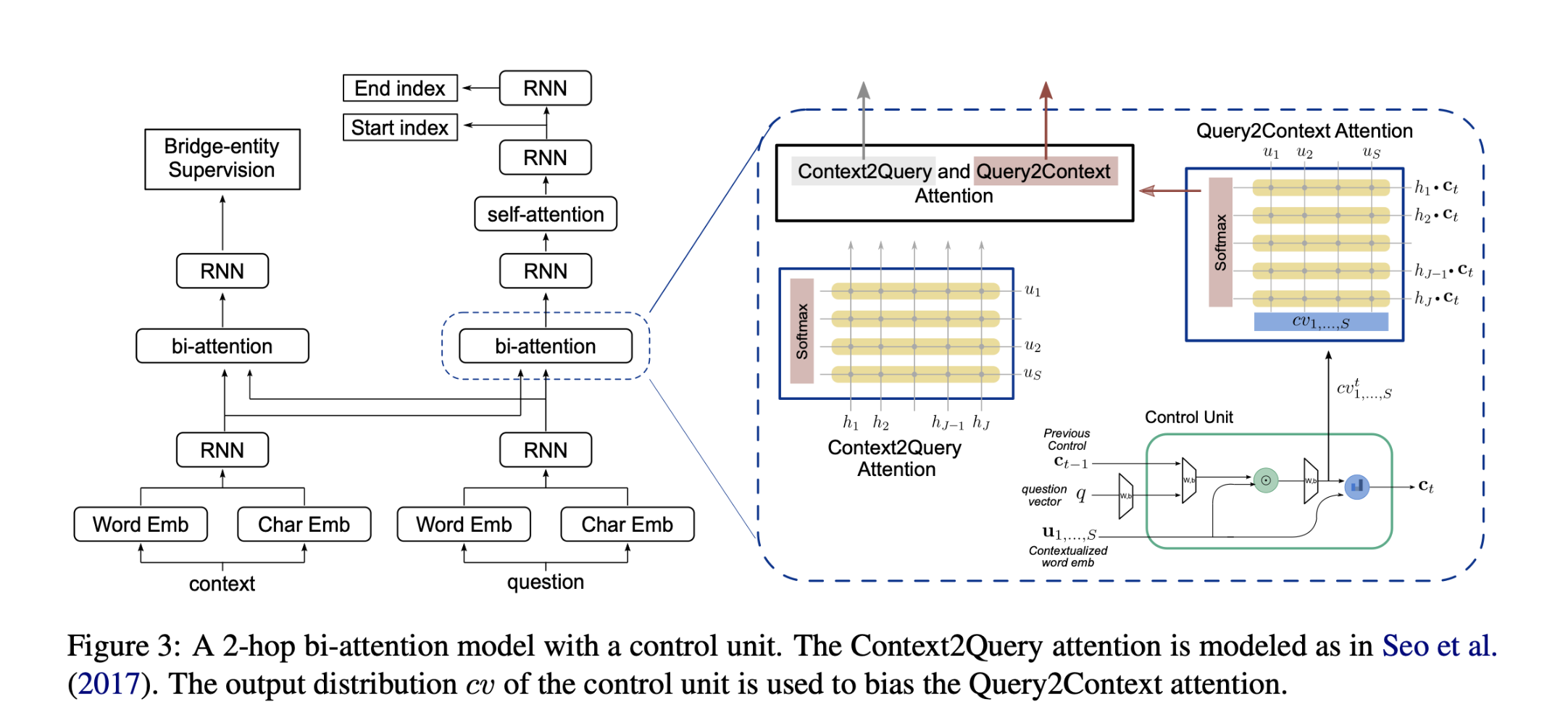

ROUGE-guided Transformer (ROT)

用来评估声明q和句子s的相关性,包括词汇和语义。

使用单层Transformer来获得Q和S的初始语义表示,该层使用BERT的第一个块初始化。

为了使ROT能够考虑词相关性,使用ROUGE指导Transformer微调。

直观上认为,词汇关联可以用表征重叠来表征,而Rouge正是用表征重叠来衡量的。

我们最小化q和s,预测结果 和 ROUGE-2之间的均方误差,以优化ROT。

- 第一部分是回归损失 。

- 第二部分限制参数的变化,因为要保持捕捉语义关联的能力。 $λ_R$是一个控制因子,Δθ表示参数的变化。

Pattern Memory Bank (PMB)

- 聚类的方式

暂时用不到,设计比较复杂,之后有兴趣可以回过头看原文。

Key Sentence Selection

一个句子是否被选为关键句是通过结合声明和模式句子相关性得分来确定的。 前者用ROT训练的q和s的距离计算公式(8),后者用PMB中最近的模式向量与残差嵌入之间的距离计算。 分数缩放为[0,1]。 对于d中的每个句子s,相关性得分计算如下:

按照相关性得分选出top-k2关键句:

Article Relevance Prediction (ARP)

Sentence representation

使用multi-layer Transformer建模更复杂的声明和关键句之间的相互作用。

$z_{q,s^{key}}$:ROT的输出

再分别计算 $z_{q,s^{key}}$中q和s的所有输出token向量的平均值,得到固定大小的句子向量 $q’ $和$$s^{key’}$。

Weighted memory-aware aggregation

对于最终预测,我们使用分数加权的记忆感知聚合。 为了让预测器知道模式信息,我们将相应的最近模式向量append到声明和关键句向量:

直观上,分数较高的句子应该多加关注,因此公式(12)的按照公式(10)的相关得分加权。

使用MLP预测得到q,d相关性概率,$\hat{y} _{q,d} > 0.5$认为相关。

交叉熵损失函数: