Heterogeneous Graph Attention Network

Heterogeneous Graph Attention Network

- Heterogeneous graph Attention Network, named HAN

异构图注意力网络

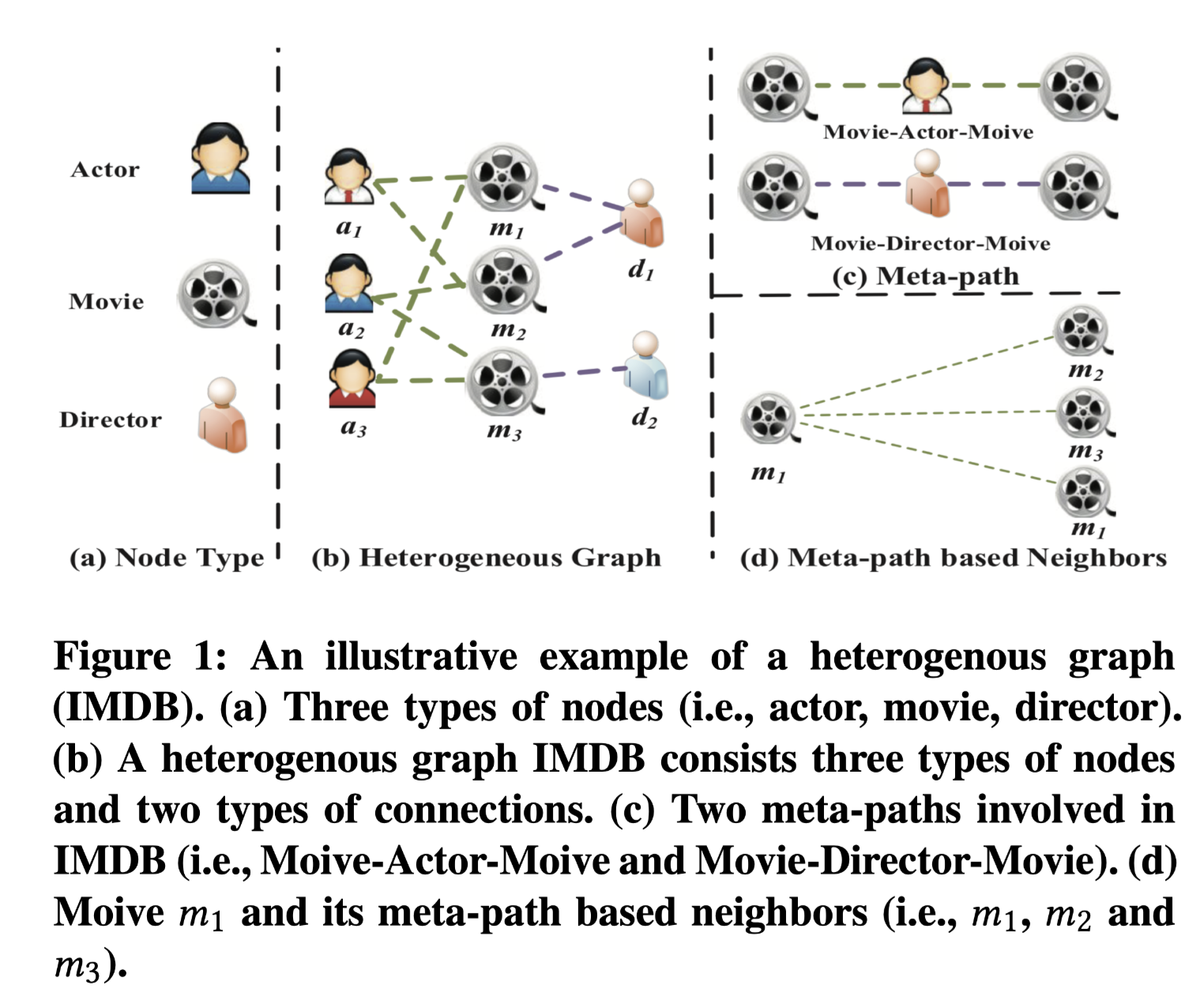

heterogeneous graph which contains different types of nodes and links

homogeneous graph which includes only one type of nodes or links

heterogeneous information network (HIN)

Meta-path, a composite relation connecting two objects, is a widely used structure to capture the semantics

论文:

代码:

任务

异构图中包含不同的节点和边,GNN做的还不够完善。由于异质图的复杂性,传统的图神经网络不能直接应用于异构图。本文提出了一种新的异构图神经网络分层注意力机制,涉及到节点级别和语义级别。节点级别的Attention主要学习节点及其临近节点间的权重,语义级别的Attention是来学习基于不同meta-path的权重。

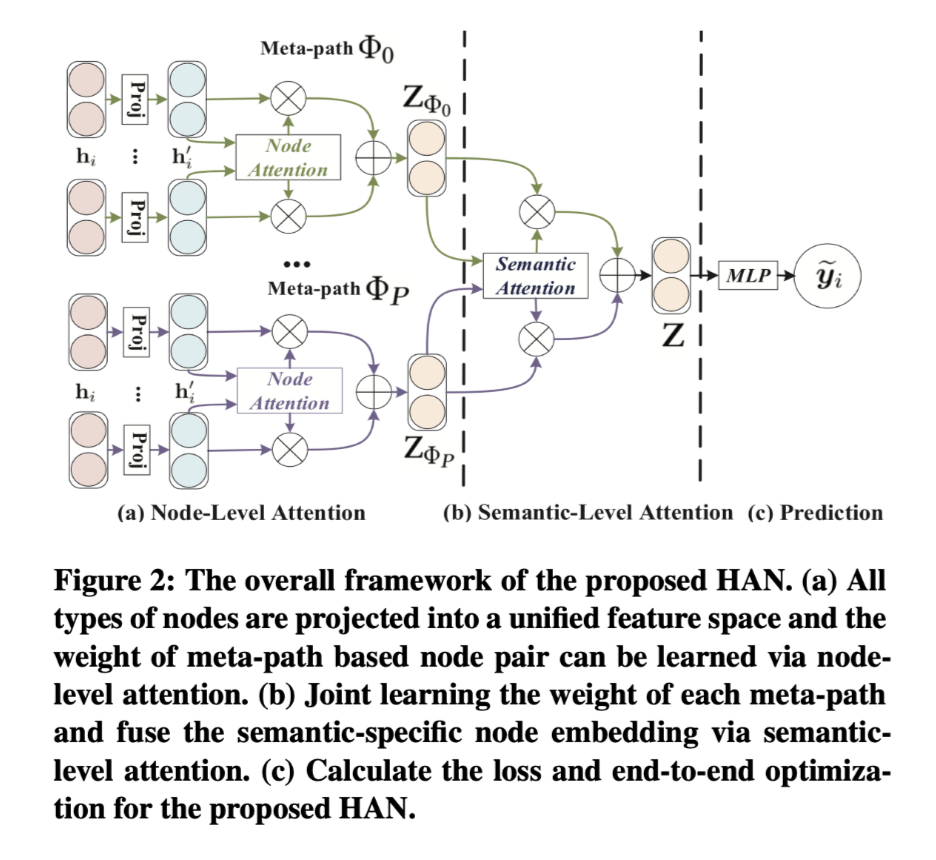

方法(模型)

- Semantic-level attention

语义级别的注意力旨在了解每个Metapath的重要性,并为他们分配适当的权重。同等对待meat-path是不切实际的,相同的权重会降低有用信息的效果。

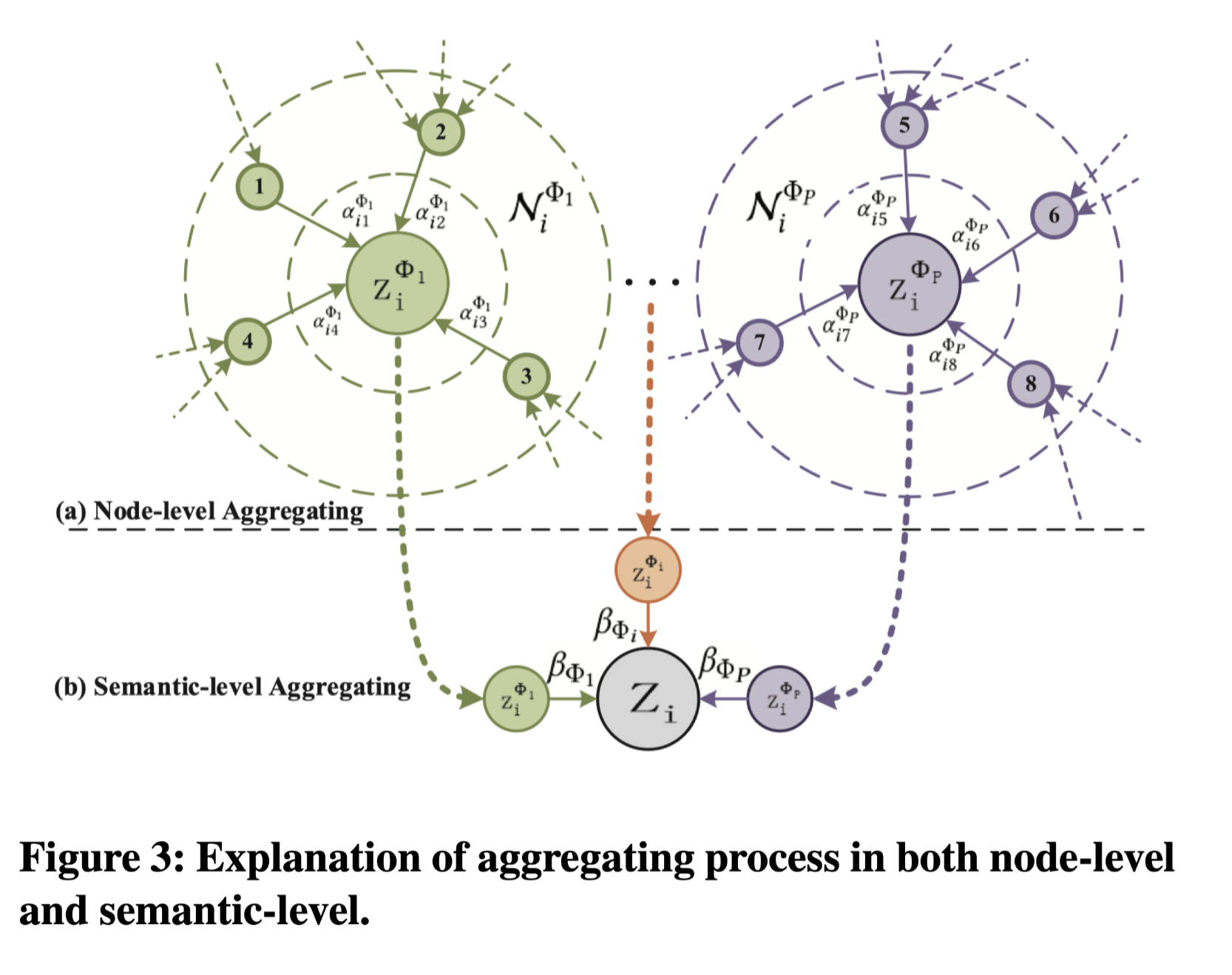

- Node-level attention

对于每个节点,节点级别注意力旨在了解基于meta-path的邻居的重要性并为它们分配不同的权重。发现节点之间的细微区别。

模型贡献:

- 本文是首次尝试研究基于注意力机制的异构图神经网络。本文的工作使得图神经网络可以直接应用于异构图,进一步方便了基于异构图的应用。

- 提出了一种新的异构图注意力网络(HAN),它包含了节点级和语义级的注意力。利用这种层次化的注意,提出的HAN可以同时考虑节点和meat-path的重要性。此外,该模型计算效率高,计算复杂度与基于元路径的节点对数目成线性关系,可应用于大规模异构图。

- 进行了大量的实验来评估所提出的模型的性能。通过与现有模型的比较,验证了该模型的优越性。更重要的是,通过分析层次注意机制,提出的HAN在异构图分析中具有良好的解释性。

模型结构:

Node-level Attention

在具体任务中,一个节点在meta-path上的邻居节点有不同的重要性。Node-level attention能够学习一个节点基于meta-path的邻居节点的表示作为该节点的embedding。由于graph中包含不同类型的node,所以首先通过转换矩阵将所有节点转换到统一的特征空间。

给定一个节点对(i , j),Node-level Attention能学习到节点j相对于节点i的权重,重要的一点是(i , j)的权重是非对称的。通过softmax计算出节点j的权重系数,得到的系数也是非对称的。

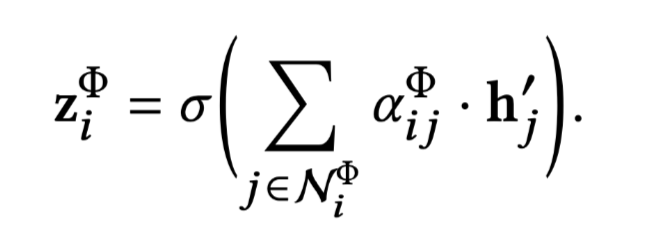

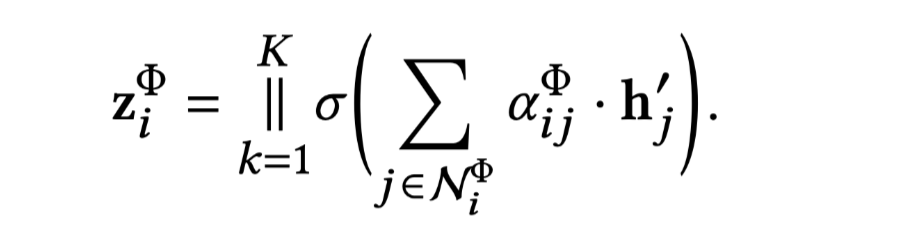

通过下面的式子聚合所有邻居节点的系数:

图示聚合过程:

由于异构图数据是scale free的,计算后会有很高的方差,本文通过将Node-level Attention延伸到了multihead Attention来解决这个问题。紧接着就可以得到Node i 的多条meta-path的embedding集合,即是语义层的embedding,就此Node-level Attention工作完成。

Semantic-level Attention

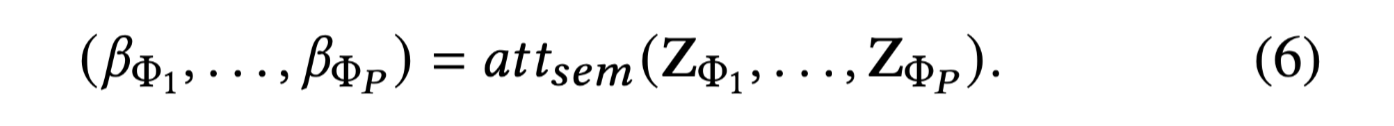

为了学习到更综合的信息,需要根据meta-path将多种语义信息融合到一起。将Node-level Attention的结果作为输入,来学习每条语义的权重。

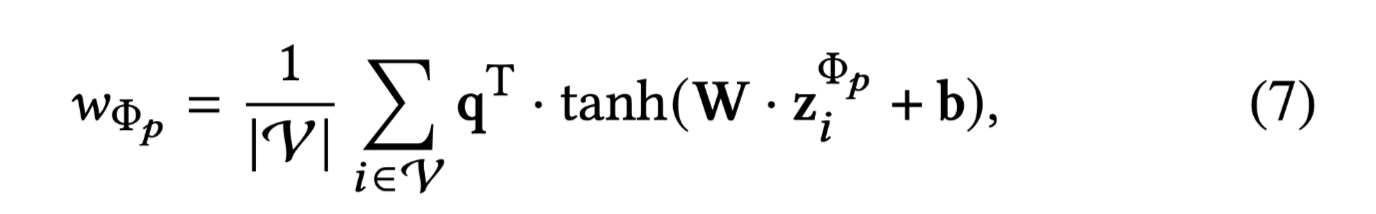

要学习每条语义的权重,首先使用一层的MLP将Semantic embedding进行非线性转换。通过Semantic-level Attention vector q 来衡量多条Semantic embedding 间的相似性。

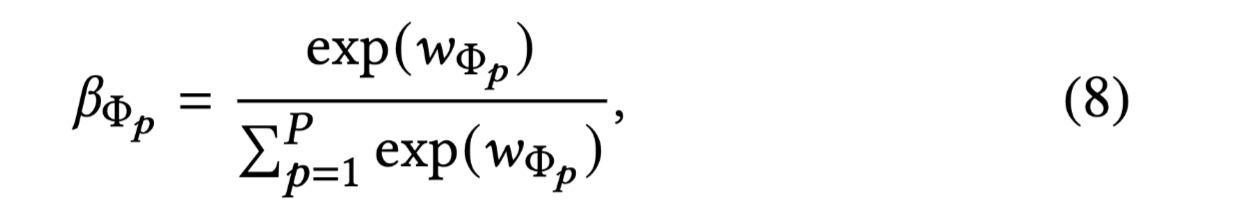

经过Softmax函数,得到语义权重。

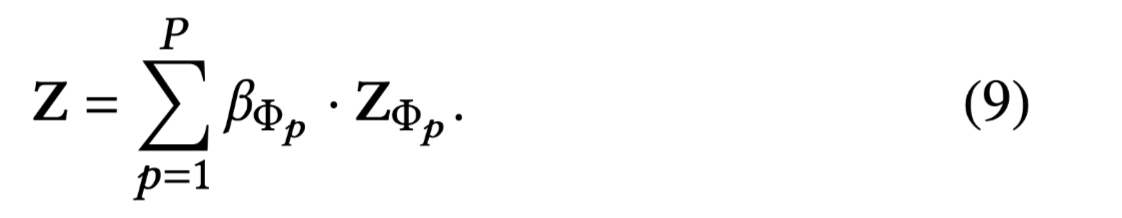

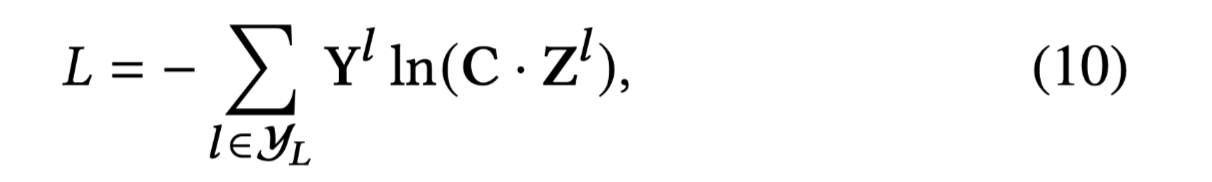

最后,获得语义层的embedding:

有了embedding之后,就可以构建loss function了,本文使用半监督的方式,通过最小化Cross-Entropy来训练。

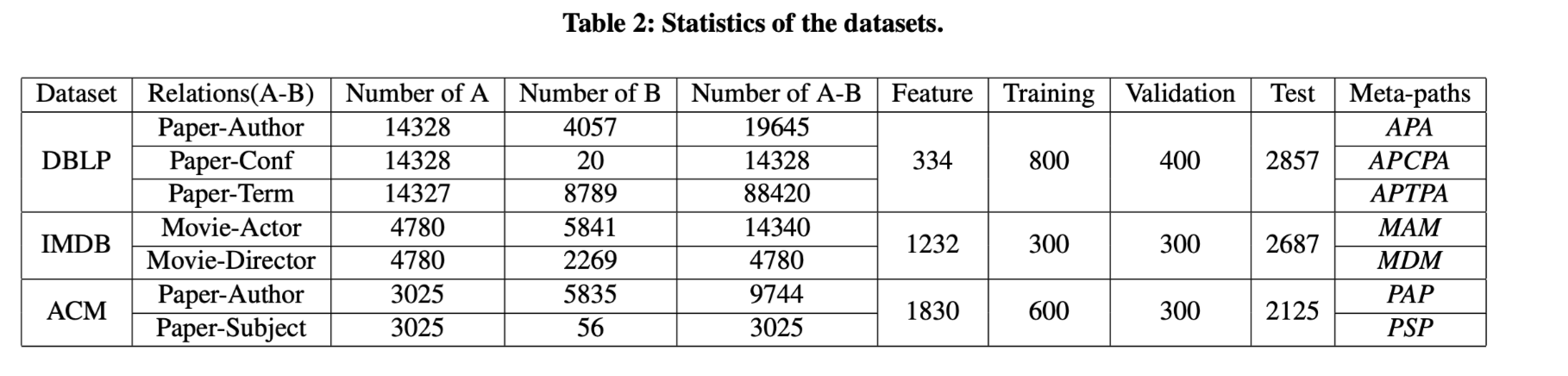

数据集

DBLP、ACM、IMDB

性能水平

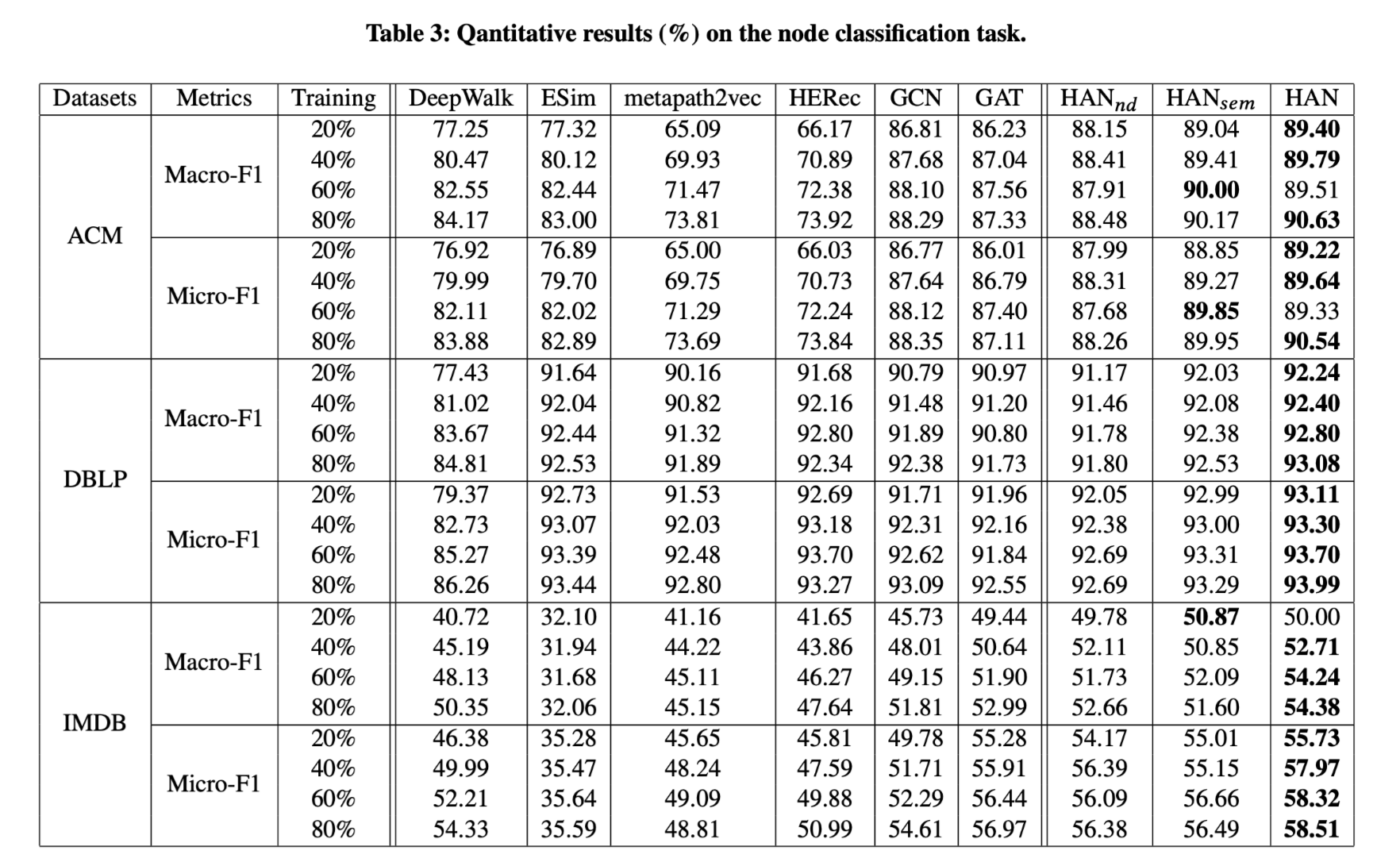

- 分类任务

由于图结构数据的方差非常高,因此重复处理10次,Table3 中为平均Macro-F1和Macro-F1。

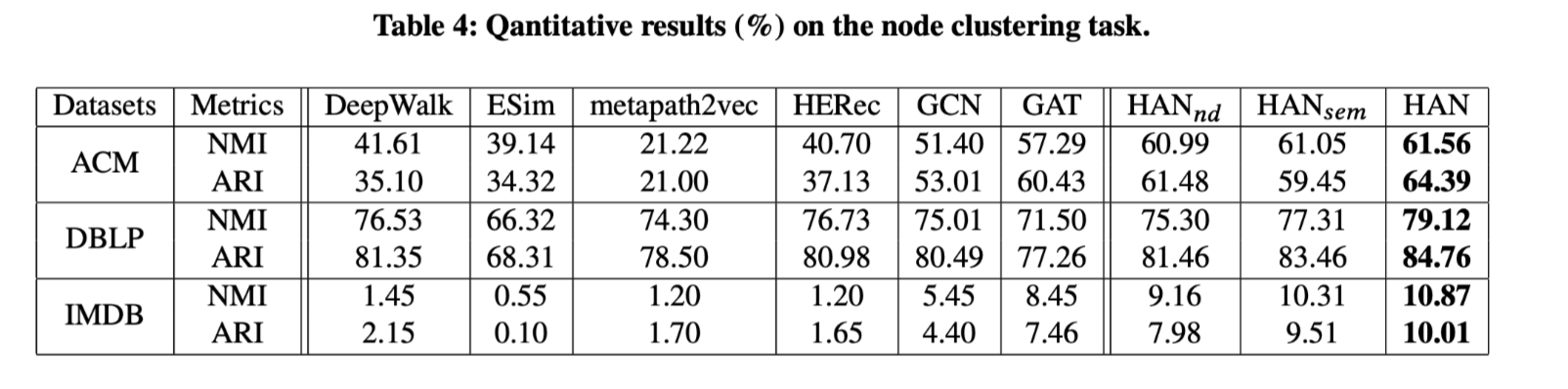

- 聚类任务

结论

本文针对异构图分析中的几个基本问题,提出了一种基于注意力机制的半监督异构图神经网络。所提出的HAN能够捕获异构图背后复杂的结构和丰富的语义。该模型利用node-level注意力和semantic-level注意力分别学习node和meta path的重要性。同时,该模型统一利用了结构信息和特征信息。实验结果包括分类和聚类,证明了HAN算法的有效性。通过分析学习到的注意力权重包括节点级和语义级,证明了HAN具有良好的解释性。